- Las Interfaces Humano Máquina han permitido el desarrollo de dos robots: una gorra que controla una silla de ruedas y unos lentes que reconocen el movimiento ocular y permiten la comunicación de un paciente con cuadriplejia.

- La revista internacional Sensors reconoció el trabajo de los investigadores al publicar un artículo.

- Tan solo en México se estima que hay 6 millones de personas con alguna discapacidad de movimiento.

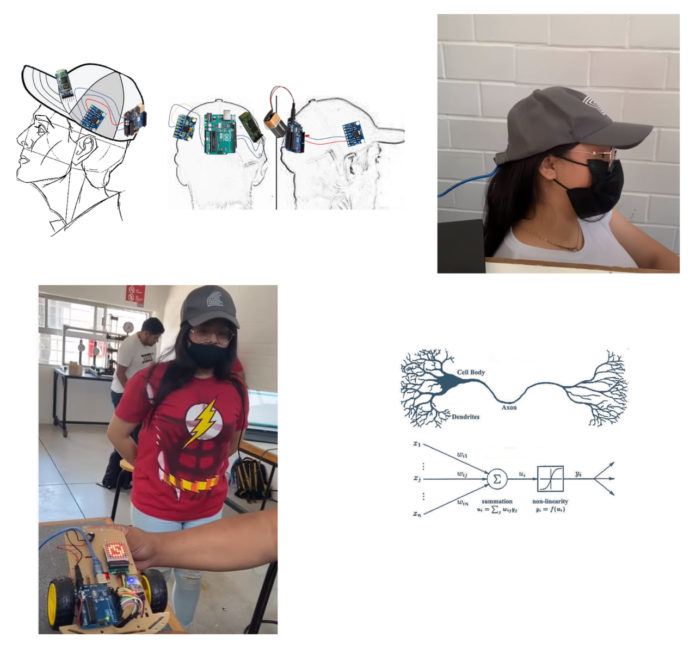

Con el propósito de ofrecer soluciones para mejorar la calidad de vida de pacientes con cuadriplejia o algún tipo de parálisis motora, investigadores de la Universidad del Valle de México, desarrollaron robots en forma de Interfases Humano Máquina. Se trata de sistemas de asistencia y rehabilitación a través de señales fisiológicas. Gracias a esto se ha permitido la fabricación de una gorra que controla una silla de ruedas y lentes que, a través de movimientos oculares, permiten la comunicación de las personas.

Innovación hecha en México

El Dr. Francisco David Pérez Reynoso, investigador del Centro de Investigación, Innovación y Desarrollo Tecnológico (CIIDETEC-UVM) y el líder de este desarrollo, explicó su funcionamiento. A través del entrenamiento de sensores con inteligencia artificial es posible la fabricación de estos dispositivos. No son invasivos y están personalizados de acuerdo con la necesidad de un paciente por su movimiento muscular, ocular o movimientos mecánicos.

Señaló que uno de los principales problemas de los avances que existen es el grado de personalización para aplicar terapia de rehabilitación. También para adaptar un sistema de asistencia a las características individuales de los pacientes. De ahí la importancia de este trabajo.

Por otro lado, recordó que de acuerdo con la Organización Mundial de la Salud (OMS), tan solo en el 2020 había más de mil millones de personas con algún tipo de discapacidad a nivel global. De ellas, alrededor de 190 millones tienen dificultades de funcionamiento que requerían servicios de asistencia.

Mientras que en México el Censo de Población y Vivienda 2020 reveló que hay más de seis millones de personas con algún tipo de discapacidad. De esta cifra el 48% tiene problemas de movilidad para caminar, subir o bajar.

El papel de la Inteligencia Artificial

El investigador indicó que para conseguir que una máquina o un dispositivo se adapte a las características o necesidades de una persona, utilizan la inteligencia artificial. Es decir, se entrena la HMI de tal forma que independientemente de la señal o el sensor que se le coloque a la interfaz, ésta lo puede interpretar como un comando de control, o comando de movimiento. De esta manera la máquina interpreta los movimientos que hace el usuario y no el usuario se tiene que adaptar a la máquina.

Lo anterior permite una disminución de tiempo significativo. Ahora se necesita un par de semanas en lugar de meses para la adaptación del robot asistencial.

Ejemplo de ello es la fabricación de una silla de ruedas, que consistió en un coche controlado con movimientos de la cabeza y una red neuronal, para posteriormente implementarlo en la silla de ruedas. La red neuronal se entrena de tal forma que entiende los comandos para poder tener el control.

Otro de los trabajos realizados fue el desarrollo de unos lentes asistenciales. A través de señales musculares a través del ojo, el paciente podía escribir texto, por ejemplo, agua o podía comunicarse a través de símbolos o de colores. Este dispositivo se fabricó para un joven que sufrió un accidente de moto y en consecuencia quedó cuadripléjico, solo tenía movimiento sobre sus ojos.

El Dr. Francisco David Pérez Reynoso destacó que, respecto a este trabajo de investigación, recientemente fue publicado su artículo Reconocimiento de patrones de señales EMG mediante aprendizaje automático para el control de un robot manipulador, por la revista internacional de divulgación científica y tecnológica Sensors.

En dicho artículo el investigador comprobó que el diseño de la HMI permitió clasificar las señales musculares en función del tiempo de contracción. El modelo implementado a través de una red neuronal logró la personalización y clasificación en tiempo real para la generación de comandos de movimiento de un robot virtual.